Brustkrebs

Brustkrebs ist weltweit die am häufigsten auftretende Krebsart bei Frauen (Sung et. al., 2021). Bei Frauen ist Brustkrebs für 1 von 4 Krebsfällen und 1 von 6 Krebstodesfällen verantwortlich, wobei er in der überwiegenden Mehrheit der Länder (159 von 185 Ländern) an erster Stelle der Inzidenz und in 110 Ländern an erster Stelle der Todesfälle steht (Sung et. al., 2021). Die meisten Fälle treten bei Frauen über 50 Jahren auf, es können jedoch auch jüngere Frauen betroffen sein. Weitere Risikofaktoren sind eine genetische Veranlagung, familiäre Vorbelastung, frühes Einsetzen der Menstruation, Hormonersatztherapie, Alkoholkonsum und Fettleibigkeit (Łukasiewicz et al., 2021).

Die Brust besteht aus milchproduzierenden Drüsenläppchen, einem System von Milchgängen und Fettgewebe (Bazira et al., 2021). Alle Brustkrebsarten haben ihren Ursprung in den Zellen, die die terminalen duktulo-lobulären Einheiten (die funktionelle Einheit der Brust) der Sammelgänge auskleiden. Die häufigste Form des männlichen Brustkrebses ist das invasive duktale Karzinom, das in den Milchgängen beginnt und in das umliegende Gewebe eindringt (Harbeck et al., 2019). An der Entstehung von Brustkrebs sind genetische Mutationen beteiligt, die eine unkontrollierte Zellvermehrung verursachen, sowie die Gene BRCA1 und BRCA2, die an der DNA-Reparatur beteiligt sind (Harbeck et al., 2019). Östrogen- und Progesteronrezeptoren spielen eine wichtige Rolle in der Pathophysiologie; alle Patienten mit Tumoren, die diese Rezeptoren exprimieren, sollten eine Hormontherapie erhalten, um die Östrogenrezeptoraktivität zu blockieren (Harbeck et al., 2019).

Brustkrebs kann auf verschiedene Weise in Erscheinung treten. Das häufigste klinische Merkmal ist ein Knoten in der Brust, Veränderungen in der Größe der Brustwarze, Ausfluss aus der Brustwarze und Hautveränderungen sowie eine Infektion und/oder Entzündung der Brust (Koo et al., 2017). Brustkrebs im Frühstadium ist häufig asymptomatisch, was die Bedeutung von Routineuntersuchungen unterstreicht (Kalager et al., 2010).

Brustkrebs wird in der Regel durch ein Screening oder ein Symptom (Schmerzen oder tastbarer Knoten) diagnostiziert, das eine diagnostische Untersuchung erfordert (McDonald et al., 2016). Dazu kommen bildgebende Verfahren, um nach Anomalien zu suchen und sie genauer zu charakterisieren (McDonald et al., 2016). Eine Brustbiopsie wird in der Regel durchgeführt, um das Vorhandensein von Krebs zu bestätigen, wenn der Verdacht besteht, und um den spezifischen Typ der Läsion zu bestimmen, wenn es sich um Krebs handelt (McDonald et al., 2016). Brustkrebs wird anhand der Ausdehnung des Tumors, der Ausbreitung auf nahe gelegene Lymphknoten, der Ausbreitung auf entfernte Stellen, des Östrogenrezeptorstatus, des Progesteronrezeptorstatus, des HER2-Status und des Grades der Krebserkrankung eingestuft (McDonald et al., 2016).

Es gibt verschiedene Arten von Brustkrebs, und die Behandlung kann je nach den molekularen Merkmalen der Krankheit einer Patientin, dem Stadium, der Krebsart und dem Rezeptorstatus variieren (Hong & Xu, 2022). Die Behandlung umfasst in der Regel eine Kombination verschiedener Methoden und ein multidisziplinäres Team von Gesundheitsexperten (Hong & Xu, 2022). Die chirurgischen Optionen reichen von brusterhaltenden Verfahren bis hin zur Mastektomie, bei der die gesamte Brust entfernt wird (Hong & Xu, 2022). Die Entfernung von Lymphknoten kann auch notwendig sein, um das Ausmaß der Krebsausbreitung zu beurteilen (Hong & Xu, 2022). Die Strahlentherapie wird häufig nach brusterhaltender Therapie oder Mastektomie (mit Risikofaktoren) eingesetzt (Hong & Xu, 2022). Die systemische Chemotherapie kann je nach Situation vor oder nach der Operation verabreicht werden (Hong & Xu, 2022). Hormonrezeptor-positiver Brustkrebs kann mit Medikamenten behandelt werden, die die Wirkung von Östrogen und Progesteron blockieren. Die Immuntherapie ist eine neue Behandlungsoption für bestimmte Brustkrebsarten, die dem Immunsystem hilft, Krebszellen zu erkennen und anzugreifen (Hong & Xu, 2022).

Bildgebungstechniken

Digitale Mammografie

Die digitale Mammografie ist die am häufigsten verwendete Technik für das Brustkrebs-Screening. Es handelt sich um eine zweidimensionale Summationstechnik, bei der die von einer Röntgenröhre ausgesandten Röntgenstrahlen in unterschiedlichem Maße von Geweben absorbiert und von einem Detektor auf der anderen Seite gemessen werden. Dichteres Gewebe erscheint auf den resultierenden Bildern heller als weniger dichtes Gewebe. Die Brüste werden bei der Bildaufnahme zusammengedrückt, um das Brustgewebe auf eine größere Fläche zu verteilen (Ikeda, 2011a). Dadurch wird die Überlappung zwischen verschiedenen Komponenten des Brustgewebes reduziert, die Streuung der durchgehenden Röntgenstrahlen verringert und der Kontrast verbessert. In der Regel werden zwei Ansichten von jeder Brust aufgenommen – kraniokaudal (CC) und mediolateral (MLO) (Ikeda, 2011a).

Die digitale Mammografie ist eine schnelle und nützliche Technik für das Brustkrebsscreening, aber sie hat auch ihre Nachteile (Ikeda, 2011a). Die Kompression der Brust kann schmerzhaft sein, und die Überlappung verschiedener Gewebe trotz der Kompression führt häufig zu Artefakten (Ikeda, 2011a). Der obere innere Quadrant der Brust, der weniger beweglich ist, da er fest mit der Brustwand verbunden ist, ist in der Mammografie besonders schwer darzustellen (Ikeda, 2011a). Auch in Brüsten mit einem hohen Anteil an dichtem Gewebe kann Krebs in der Mammografie sehr schwer zu erkennen sein (Ikeda, 2011a).

Digitale Brusttomosynthese

Bei der digitalen Brusttomosynthese (DBT) werden die Bilder mithilfe einer Röntgenröhre aufgenommen, die eine Bogenbewegung ausführt. Dünne Schichten werden rekonstruiert und ermöglichen eine 3D-Bildgebung, die den Einfluss von überlappendem Brustgewebe minimieren soll und besonders nützlich für die Darstellung von Brustläsionen ist, die sich in einem heterogenen und dichten Brustparenchym befinden. Eine Studie ergab, dass die DBT bei der Erkennung von Brustkrebs empfindlicher ist als die digitale Mammografie (DM). Die DBT kann mit der DM kombiniert werden, und eine Studie ergab, dass die Kombination dieser Techniken die Erkennung von Brustkrebs verbessert (Alabousi et al., 2020; Lei et al., 2014; Skaane et al., 2019), und die Kombination mit der Mammografie möglich ist. Die DBT dauert jedoch länger als die Mammografie und ist mit Bewegungs- und anderen Artefakten behaftet (Tirada et al., 2019).

Ultraschall

Beim diagnostischen Ultraschall sendet ein Schallkopf Hochfrequenz-Schallwellen aus, die sich durch das Gewebe bewegen, an diesem abprallen und „Echos“ erzeugen, die auf den Schallkopf zurückgeworfen und von diesem erkannt werden. Diese Echoaufnahmen werden dann verarbeitet, um Echtzeitbilder auf einem Monitor zu erstellen, die auf der Zeit basieren, die die Ultraschallwellen für den Weg zum Gewebe und zurück benötigen. Es handelt sich um eine sichere und relativ kostengünstige Technik, die häufig als Ergänzung zur Mammografie eingesetzt wird (Ikeda, 2011b), insbesondere zur weiteren Beurteilung eines tastbaren oder mammografischen Befunds.

Sie kann sogar als primäre Screening-Methode bei Frauen unter 30 Jahren oder bei schwangeren oder stillenden Frauen eingesetzt werden (Dixon, 2008; Ikeda, 2011b). Ultraschall ist sehr nützlich, um zu klären, ob eine Masse zystisch oder solide ist, welche Art von Rändern sie hat und ob sie vaskulär ist (Dixon, 2008; Ikeda, 2011b). Sie hilft auch, andere Massen und verdächtige axilläre Lymphknoten zu entdecken (Dixon, 2008; Ikeda, 2011b). Der größte Nachteil ist, dass die Qualität der Untersuchung stark bedienerabhängig ist (Dixon, 2008; Ikeda, 2011b).

Magnetresonanztomographie

Mithilfe eines starken Magnetfelds und einer Reihe von Hochfrequenzwellen richtet die Magnetresonanztomographie (MRT) die Wasserstoffkerne im Gewebe gleichmäßig aus, um detaillierte Querschnittsbilder des Körpers zu erstellen (Daniel & Ikeda, 2011; Mann et al., 2019). Da Gewebe mit unterschiedlicher Zusammensetzung auf diese Störung unterschiedlich reagieren, kann die MRT selbst kleinste Unterschiede zwischen verschiedenen Weichgewebetypen sehr gut nachweisen und gilt als die genaueste Methode zur Diagnose von Brustkrebs (Daniel & Ikeda, 2011; Mann et al., 2019). Sie wird hauptsächlich für das Screening von Hochrisikopatienten auf der Grundlage genetischer oder erworbener Risikofaktoren verwendet (Daniel & Ikeda, 2011).

Für die MRT der Brust sind spezielle Brustspulen erforderlich, die die Hochfrequenzwellen aussenden und das erzeugte Signal empfangen. Die Bilder werden häufig mit einer räumlichen Auflösung von 1 mm in der Ebene, einer Schichtdicke von weniger als 3 mm und einer Unterdrückung des Fettgewebesignals aufgenommen. Zu den häufig verwendeten Sequenzen gehören T2-gewichtete Bilder, diffusionsgewichtete Bilder und dynamische kontrastverstärkte MRT. Um falsch-positive Ergebnisse aufgrund unspezifischer Veränderungen des Brustparenchyms zu vermeiden, wird die Untersuchung am besten zwischen Tag 7 und 13 des Menstruationszyklus durchgeführt (Daniel & Ikeda, 2011). Anders als bei der Mammografie werden bei der MRT keine ionisierenden Strahlen eingesetzt und dreidimensionale Bilder erzeugt, die die Erkennung sehr kleiner Läsionen ermöglichen (DeMartini & Lehman, 2008; Shahid et al., 2016). Die MRT ermöglicht auch eine detailliertere Beurteilung der Brustwand als die Mammografie und der Ultraschall (DeMartini & Lehman, 2008). Zu den Nachteilen der Brust-MRT gehören die geringe Erkennungsfähigkeit von Mikroverkalkungen, die hohen Kosten und die Tatsache, dass sie bei Personen mit bestimmten Metallimplantaten kontraindiziert ist (Daniel & Ikeda, 2011).

Screening- und Diagnoseherausforderungen

Trotz der Belege für den allgemeinen Nutzen des Brustkrebsscreenings (Dibden et al., 2020; Kalager et al., 2010; Tabár et al., 2019) ist es mit mehreren technischen und logistischen Herausforderungen behaftet. Bei mehr als der Hälfte der Frauen, die 10 Jahre lang jährlich untersucht werden, fällt der Test falsch positiv aus (Hubbard et al., 2011). Dies hat weitreichende und signifikante Folgen, einschließlich der physischen und emotionalen Belastung durch unnötige Biopsien und erhöhte Gesundheitskosten (Nelson, Pappas, et al., 2016; Ong & Mandl, 2015). Auch beim Screening wird Brustkrebs häufig übersehen, insbesondere bei Frauen mit dichter Brust (Banks et al., 2006).

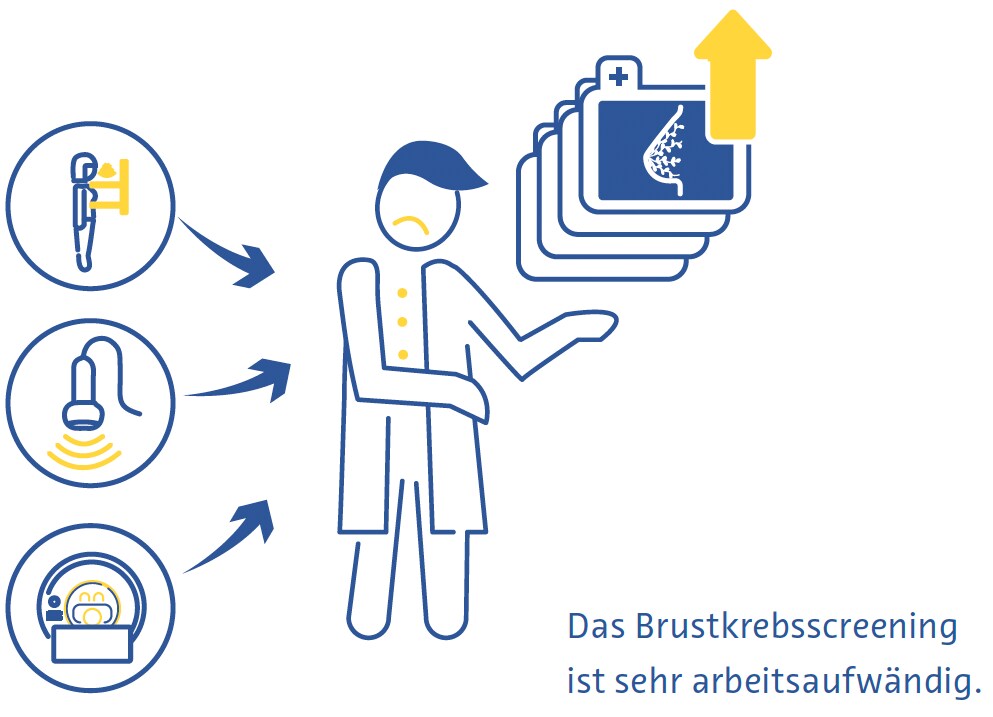

Das Brustkrebsscreening erfordert hochqualifizierte Fachkräfte, darunter Radiologen und Röntgenassistenten, an denen es derzeit weltweit mangelt (Moran & Warren-Forward, 2012; Rimmer, 2017; Wing & Langelier, 2009). Dieses Problem wird durch die Tatsache verschärft, dass in vielen europäischen Ländern der Standard der Versorgung beim Brustscreening darin besteht, dass jede Auswertung von zwei Radiologen unabhängig voneinander durchgeführt wird (Giordano et al., 2012), und dass in bestimmten Ländern, wie z. B. in den USA, die Hürden für die Qualifikation zur Interpretation von Mammogrammen aufgrund strenger beruflicher Zulassungsstandards hoch sind (Food and Drug Administration, 2001).

Außerdem gibt es weltweit erhebliche Hindernisse für die Inanspruchnahme des Brustkrebsscreenings. Dazu gehören der fehlende oder schwierige Zugang zu Früherkennungsprogrammen, mangelndes Wissen oder Missverständnisse über den Nutzen dieser Programme sowie soziale und kulturelle Barrieren (Mascara & Constantinou, 2021).

Rolle der künstlichen Intelligenz

Technische Verbesserungen

Bisher gibt es nur wenige veröffentlichte Studien, die den Einsatz von KI zur technischen Verbesserung von Brustuntersuchungen direkt untersucht haben. Eine kommerziell erhältliche Anwendung gibt dem Röntgenpersonal in Echtzeit Rückmeldung über die korrekte Positionierung der Patientin bei Mammografien. (Volpara Gesundheit, 2022). Andere KI-Anwendungen konzentrieren sich auf die Verringerung der Strahlendosis (J. Liu et al., 2018), die Verbesserung der Bildrekonstruktion (Kim et al., 2016) und die Reduzierung von Rauschen und Artefakten bei der DBT (Garrett et al., 2018).

Beim Brustkrebsscreening wird die DBT häufig mit der digitalen Mammografie kombiniert, wodurch sich die Strahlendosis für die Patientinnen und Patienten verdoppelt (Svahn et al., 2015). Um dies zu vermeiden, hat das Interesse an der Erstellung synthetischer Mammogramme aus DBT-Daten zugenommen (Chikarmane et al., 2023). In einer großen prospektiven norwegischen Studie war die Genauigkeit der DBT in Kombination mit digitaler Mammografie oder synthetischer Mammografie bei der Brustkrebserkennung sehr ähnlich (Skaane et al., 2019). Jüngste Studien haben die Verbesserung der Qualität der synthetischen Mammografie durch KI untersucht und vielversprechende Ergebnisse erzielt (Balleyguier et al., 2017; James et al., 2018).

Diagnostische Verbesserungen

Beurteilung der Brustdichte

Dichtes Brustgewebe, das auf der Mammografie sichtbar ist, stellt fibroglanduläres Gewebe dar. Frauen mit dichten Brüsten haben ein 2- bis 4-fach höheres Brustkrebsrisiko als Frauen mit Brüsten mit mehr fetthaltigem Brustgewebe (Byrne et al., 1995; Duffy et al., 2018; Torres-Mejía et al., 2005). Darüber hinaus ist die Sensitivität der Mammografie für Brustkrebs in dichten Brüsten um 20-30 % geringer als in weniger dichten Brüsten (Lynge et al., 2019). Der Standard für die Beurteilung der Brustdichte ist die BI-RADS-Klassifikation (Berg et al., 2000).

Mehrere große Studien haben das Potenzial für die automatische Bewertung der Brustdichte auf Mammo-grammen mithilfe von KI-basierten Tools untersucht. Ein konvolutionales neuronales Netz (aus dem Englischen für CNN: Convolutional Neural Network) das auf 14.000 Mammogrammen trainiert und auf fast 2000 Mammo-grammen getestet wurde, klassifizierte die Brustdichte entweder als „verstreut dicht“ oder „heterogen dicht“ mit einer Fläche unter der Kurve (AUC) von 0,93 (Mo-hamed et al., 2018). In einer anderen Studie wurde ein CNN verwendet, das sowohl eine binäre als auch eine vierfache BI-RADSKlassifizierung durchführen kann und mit mehr als 40 000 Mammogrammen trainiert wurde (Lehman et al., 2019). In einem Testdatensatz von mehr als 8.000 Mammogrammen fanden sie einen hohen Grad an Übereinstimmung bei der Brustdichte zwischen dem Algorithmus und einzelnen Radiologen (kappa = 0,67) sowie dem Konsens von fünf Radiologen (kappa = 0,78) (Lehman et al., 2019).

Brustkrebserkennung

In einer systematischen Übersichtsarbeit, die 82 Studien mit KI zur Brustkrebserkennung mit verschiedenen Referenzstandards umfasste, fanden die Autoren eine AUC von 0,87 für Studien mit Mammografie, 0,91 mit Ultraschall, 0,91 mit DBT und 0,87 mit MRT (Aggarwal et al., 2021). Dies sind vielversprechende Ergebnisse, doch ein direkter Vergleich zwischen KI-basierten Algorithmen und Radiologen zeigt, dass es noch Raum für Verbesserungen gibt. In einer anderen systematischen Überprüfung von Studien, in denen entweder die Histopathologie oder die Nachbeobachtung (bei Screening-negativen Frauen) als Referenz herangezogen wurde, waren 94 % der 36 identifizierten CNNs weniger genau als ein einzelner Radiologe, und alle waren weniger genau als der Konsens von zwei oder mehr Radiologen, wenn sie als eigenständiges System verwendet wurden (Freeman et al., 2021). Die derzeitigen Erkenntnisse sprechen daher nicht für den Einsatz von KI als alleinige Strategie zur Brustkrebserkennung.

Brustkrebsvorhersage

KI hat sich als vielversprechend für die Vorhersage des Brustkrebsrisikos auf der Grundlage von Screening- Mammogrammen erwiesen, entweder durch eine bessere Bewertung der Brustdichte, einem etablierten Risikofaktor für Brustkrebs (Duffy et al., 2018), oder durch die Erkennung feinster Bildgebungsmerkmale, die Vorboten von Krebs sind (Batchu et al., 2021). In mehreren Studien wurden KI-basierte Modelle verwendet, um das Risiko, in Zukunft an Brustkrebs zu erkranken, auf der Grundlage von Mammogrammen vorherzusagen (Batchu et al., 2021; Geras et al., 2019).

Ein CNN, das auf fast 1 000 000 Mammografie-Bildern trainiert wurde, zeigte eine AUC von 0,65 für die Vorhersage der zukünftigen Entwicklung von Brustkrebs im Vergleich zu 0,57-0,60 für konventionelle Mammografie- basierte Brustdichte-Scores (Dembrower, Liu, et al., 2020). Eine kleinere Studie ergab einen AUC-Wert von 0,73 für eine CNN-basierte Methode zur Vorhersage von Brustkrebs aus normalen Mammografiebildern. (Arefan et al., 2020). Ein anderer Deep-Learning-Algorithmus zeigte eine AUC von 0,82 für die Vorhersage von Intervallkrebs (Krebs, der innerhalb von 12 Monaten nach einer negativen Mammografie entdeckt wurde) im Vergleich zu 0,65 für die visuelle BI-RADS-Bewertung der Brustdichte (Hinton et al., 2019). Ein anderes Deep- Learning-basiertes Modell, das sowohl Risikofaktoren als auch mammografische Befunde zur Vorhersage des Brustkrebsrisikos einbezog, hatte eine AUC von bis zu 0,7 und übertraf damit die Genauigkeit von Vorhersagemodellen, die nur auf Risikofaktoren oder mammografischen Befunden basieren. (Yala, Lehman, et al., 2019).

Effizienzsteigerungen

Die schiere Menge an mammografischen Untersuchungen und der Mangel an geschulten Radiologen haben Effizienzsteigerungen zu einem der interessantesten Forschungsbereiche für den Einsatz von KI bei Brustkrebs gemacht.

In einer Studie simulierten die Autoren einen Arbeitsablauf, bei dem Mammogramme von einem Radiologen und einem Deep-Learning-Modell interpretiert wurden, wobei die Entscheidung als endgültig galt, wenn beide übereinstimmten (McKinney et al., 2020). Ein zweiter Radiologe wurde nur bei Nichtübereinstimmung hinzugezogen, was mit einer 88%igen Verringerung des Arbeitsaufwands für den zweiten Radiologen und einem negativen Vorhersagewert von über 99,9 % verbunden war (McKinney et al., 2020).

In einer erstmalig durchgeführten großen randomisierten klinischen Studie in Schweden wurden etwa 80 000 Frauen ausgewählt, deren Screening-Mammogramme entweder einer Vorauswertung durch einen CNN unterzogen wurden oder nicht (Lång et al., 2023). In der Untersuchungsgruppe wurden nur Mammogramme, denen eine hohe Malignitätswahrscheinlichkeit zugewiesen wurde, doppelt ausgewertet (der Rest wurde von einem Radiologen ausgewertet), und die Ergebnisse wurden mit der herkömmlichen doppelten Auswertung ohne Hilfe des Algorithmus verglichen. In einer Zwischenanalyse der Daten der 80.000 Frauen zeigten beide Studienarme eine identische Falsch-Positiv-Rate von 1,5 %. Der positive Vorhersagewert der Befundung betrug in der Untersuchungsgruppe 28,3 % und in der Kontrollgruppe 24,8 %, und der Arbeitsaufwand wurde durch die Strategie um 44,3 % reduziert (Lång et al., 2023).

In anderen Studien wurde die KI zur Voruntersuchung von Mammogrammen eingesetzt, wobei diejenigen mit einer geringen Krebswahrscheinlichkeit aussortiert wurden und nur diejenigen mit einer hohen Krebswahrscheinlichkeit einem Radiologen vorgelegt wurden. In einer Studie aus den USA wurde zu diesem Zweck ein simulierter Arbeitsablauf verwendet, bei dem ein CNN auf mehr als 212 000 Mammogrammen trainiert und auf über 26 000 getestet wurde (Yala, Schuster, et al., 2019). Der Arbeitsablauf unter Verwendung des Algorithmus hatte eine nicht unterlegene Sensitivität für Brustkrebs (90,1 % vs. 90,6 %) und eine etwas höhere Spezifität im Vergleich zu allein arbeitenden Radiologen (94,2 % gegenüber 93,5 %) und war mit einem um 19,3 % geringeren Arbeitsaufwand verbunden (Yala, Schuster, et al., 2019). Eine kleinere Studie aus Spanien ergab eine Verringerung des Arbeitsaufwands um 72,5 %, wenn die KI nur DBT-Fälle mit hohem Risiko für die Auswertung durch einen zweiten Radiologen auswählte, und um 29,7 %, wenn die KI nur DBT-Studien mit hohem Risiko für die Auswertung durch einen zweiten Radiologen auswählte, im Vergleich zu herkömmlichen Mammografie-Workflows mit doppelter Auswertung (Raya-Povedano et al., 2021). Sie stellten außerdem fest, dass diese Strategie, bei der KI zur Auswahl von Mammografie- und DBT-Fällen mit hohem Risiko für eine zweite Auswertung eingesetzt wird, im Vergleich zu den standardmäßigen Mammografie- und DBT- Workflows mit doppelter Auswertung eine nicht schlechtere Sensitivität aufweist (Raya-Povedano et al., 2021). In einer schwedischen Studie ergab eine ähnliche Strategie unter Verwendung eines kommerziell verfügbaren KI-Algorithmus eine Falsch-Negativ-Rate von nicht mehr als 4 %, und der Algorithmus zeigte die Fähigkeit, möglicherweise 71 zusätzliche Krebsfälle pro 1000 Untersuchungen zu entdecken, mehr als eine doppelte Bewertung auf negative Befunde durch menschliche Radiologen bei Patienten, die der KI-Algorithmus als sehr risikoreich einstufte (Dembrower, Wåhlin, et al., 2020).

In einer Studie mit über einer Million Mammogrammen an acht Screening-Standorten und von drei Geräteherstellern hat ein kommerziell erhältlicher Deep-Learning- Algorithmus auf der Grundlage von Bewertungen mit hoher Konfidenz 63 % der Untersuchungen so eingestuft, dass sie nicht weiter verfolgt werden sollten (Leibig et al., 2022). Der Rest der Untersuchungen, bei denen der Algorithmus eine geringe Konfidenz aufwies, wurde den Radiologen vorgelegt. Diese Strategie verbesserte die Sensitivität der Radiologen (im Vergleich zur nicht unterstützten Auswertung) um 2,6-4 % und die Spezifität um 0,5-1,0 % (Leibig et al., 2022).

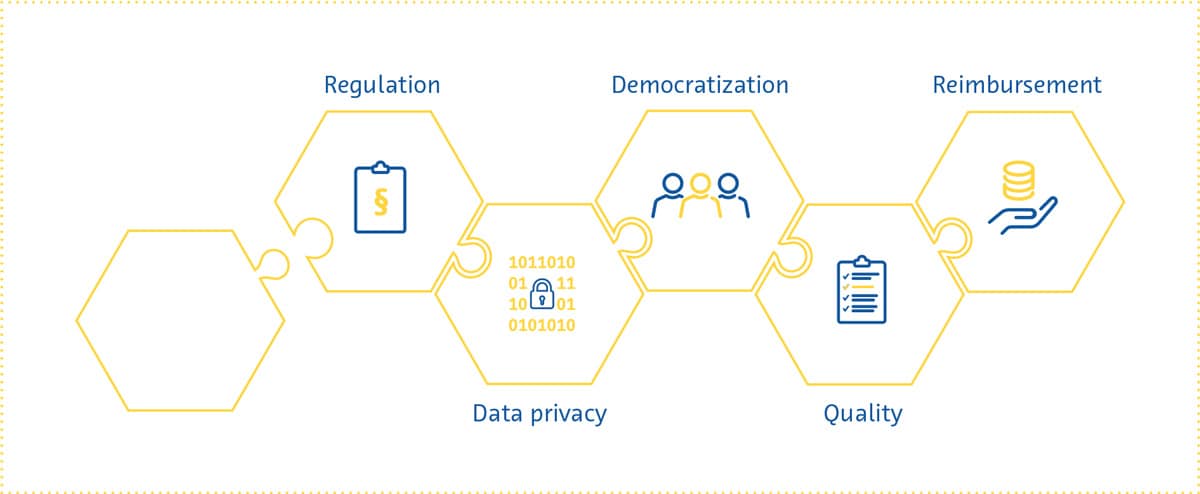

Herausforderungen und zukünftige Wege

Mehrere ethische, technische und methodische Herausforderungen, die mit dem Einsatz von KI in der Brustkrebsvorsorge verbunden sind, bilden einen Rahmen für die künftige Forschung zu diesem Thema (Hickman et al., 2021).

Die meisten KI-basierten Tools haben sich bisher auf die digitale Mammografie konzentriert (Aggarwal et al., 2021), aber andere Untersuchungstechniken wie DBT und MRT haben einzigartige Vorteile (Alsheik et al., 2019; Mann et al., 2019) und werden in Zukunft wahrscheinlich eine größere Rolle beim Brustkrebs-Screening spielen. Da es sich bei DBT und MRT jedoch um tomografische Verfahren handelt, die dreidimensionale Ergebnisse liefern, erfordert die Verarbeitung mit KI-basierten Tools mehr Speicherplatz und Rechenleistung (Prevedello et al., 2019).

Inzidenz, Verlauf und Ergebnis von Brustkrebs hängen mit verschiedenen soziodemografischen Faktoren zusammen, darunter ethnische Herkunft und Zugehörigkeit (Hirko et al., 2022; Hu et al., 2019; Martini et al., 2022). Das Training von KI-basierten Hilfsmitteln mit Datensätzen, die ein breites Spektrum der Menschen repräsentieren, ist der Schlüssel, um sicherzustellen, dass sie verallgemeinert werden können und so vielen Menschen wie möglich nützen.

Die allgemeine Leistung der KI bei der Erkennung von Brustkrebs ist beeindruckend. Es ist jedoch hervorzuheben, dass in einer Studie nicht nachgewiesen werden konnte, dass die Sensitivität der KI bei der Erkennung von Brustkrebs derjenigen von Radiologen nicht unterlegen ist (Lauritzen et al., 2022). Darüber hinaus ist die Qualität der Nachweise in vielen Studien zu diesem Thema fraglich. Eine systematische Überprüfung der Genauigkeit von KI-basierten Tools für die Brustkrebserkennung ergab mehrere Bereiche mit Verbesserungspotenzial (Freeman et al., 2021). Bei der Überprüfung wurden keine prospektiven Studien gefunden, und die identifizierten Studien waren von schlechter methodischer Qualität. Insbesondere stellten die Autoren fest, dass kleinere Studien positivere Ergebnisse zeigten, die sich in größeren Studien nicht wiederholen ließen. In einer anderen systematischen Übersichtsarbeit wurde nur in etwa einem Zehntel der Studien ein externer Datensatz zur Validierung herangezogen, in keiner Studie wurde eine vorgegebene Stichprobengröße berechnet, und es wurden schwerwiegende Probleme mit Selektionsverzerrungen und unangemessenen Referenzstandards festgestellt (Aggarwal et al., 2021). Diese methodischen Probleme können in Zukunft möglicherweise durch die Einführung großer offener Datenbestände (Nguyen et al., 2023) und die verstärkte Einhaltung von Leitlinien für die Durchführung KI-gestützter medizinischer Forschung (Lekadir et al., 2021; X. Liu et al., 2020) entschärft werden.

Fazit

Die Integration von künstlicher Intelligenz in Mammographie-Screening Programme zur Brustkrebs- Früherkennung verspricht, die Bildqualität, Effi-zienz und Vorhersage des zukünftigen Brustkrebsrisikos zu verbessern. Bei der Erkennung von Brustkrebs bei Screening-Untersuchungen zeigt sich, dass künstliche Intelligenz am besten funktioniert, wenn sie gemeinsam mit Radiologen eingesetzt wird. Die laufende Forschung ist von entscheidender Bedeutung, um die mit dem Einsatz von KI in der Brustkrebsvorsorge verbundenen Herausforderungen zu bewältigen, einschließlich der Ausweitung ihrer Anwendungen über die Mammografie hinaus und der Gewährleistung ihres ethischen und ver-antwortungsvollen Einsatzes. Mit der kontinuierlichen Weiterentwicklung von KIAnwendungen birgt die Zukun-ft der Brustkrebsvorsorge ein immenses Potenzial für eine bessere Zugänglichkeit, ein frühzeitiges Intervention und letztlich bessere Ergebnisse für die Patientinnen.

Literaturverzeichnis

Aggarwal, R., Sounderajah, V., Martin, G., Ting, D. S. W., Karthikesalingam, A., King, D., Ashrafian, H., & Darzi, A. (2021). Diagnostic accuracy of deep learning in medical imaging: a systematic review and meta-analysis. NPJ Digital Medicine, 4(1), 65.

Alabousi, M., Zha, N., Salameh, J.-P., Samoilov, L., Sharifabadi, A. D., Pozdnyakov, A., Sadeghirad, B., Freitas, V., McInnes, M. D. F., & Alabousi, A. (2020). Digital breast tomosynthesis for breast cancer detection: a diagnostic test accuracy systematic review and meta-analysis. European Radiology, 30(4), 2058–2071.

Alkabban FM and Ferguson T. (2022). Breast Cancer, 2022. In: StatPearls [Internet]. Treasure Island (FL): StatPearls Publishing.

Alsheik, N. H., Dabbous, F., Pohlman, S. K., Troeger, K. M., Gliklich, R. E., Donadio, G. M., Su, Z., Menon, V., & Conant, E. F. (2019). Comparison of Resource Utilization and Clinical Outcomes Following Screening with Digital Breast Tomosynthesis Versus Digital Mammography: Findings From a Learning Health System. Academic Radiology, 26(5), 597–605.

Arefan, D., Mohamed, A. A., Berg, W. A., Zuley, M. L., Sumkin, J. H., & Wu, S. (2020). Deep learning modeling using normal mammograms for predicting breast cancer risk. Medical Physics, 47(1), 110–118.

Balleyguier, C., Arfi-Rouche, J., Levy, L., Toubiana, P. R., Cohen-Scali, F., Toledano, A. Y., & Boyer, B. (2017). Improving digital breast tomosynthesis reading time: A pilot multi-reader, multi-case study using concurrent Computer-Aided Detection (CAD). European Journal of Radiology, 97, 83–89.

Banks, E., Reeves, G., Beral, V., Bull, D., Crossley, B., Simmonds, M., Hilton, E., Bailey, S., Barrett, N., Briers, P., English, R., Jackson, A., Kutt, E., Lavelle, J., Rockall, L., Wallis, M. G., Wilson, M., & Patnick, J. (2006). Hormone replacement therapy and false positive recall in the Million Women Study: patterns of use, hormonal constituents and consistency of effect. Breast Cancer Research: BCR, 8(1), R8.

Batchu, S., Liu, F., Amireh, A., Waller, J., & Umair, M. (2021). A Review of Applications of Machine Learning in Mammography and Future Challenges. Oncology, 99(8), 483–490. https://doi.org/10.1159/000515698

Bazira, P. J., Ellis, H., & Mahadevan, V. (2022). Anatomy and physiology of the breast. Surgery, 40(2), 79–83. https://doi.org/10.1016/j.mpsur.2021.11.015

Berg, W. A., Campassi, C., Langenberg, P., & Sexton, M. J. (2000). Breast Imaging Reporting and Data System: interand intraobserver variability in feature analysis and final assessment. AJR. American Journal of Roentgenology, 174(6), 1769–1777.

Boyd, N. F., Guo, H., Martin, L. J., Sun, L., Stone, J., Fishell, E., Jong, R. A., Hislop, G., Chiarelli, A., Minkin, S., & Yaffe, M. J. (2007). Mammographic density and the risk and detection of breast cancer. The New England Journal of Medicine, 356(3), 227–236.

Bray, F., Ferlay, J., Soerjomataram, I., Siegel, R. L., Torre, L. A., & Jemal, A. (2018). Global cancer statistics 2018: GLOBOCAN estimates of incidence and mortality worldwide for 36 cancers in 185 countries. CA: A Cancer Journal for Clinicians, 68(6), 394–424.

Breast Cancer Statistics. (2020, October 27). Susan G. Komen®. https://www.komen.org/breast-cancer/facts-statistics/breastcancer- statistics/

Byrne, C., Schairer, C., Wolfe, J., Parekh, N., Salane, M., Brinton, L. A., Hoover, R., & Haile, R. (1995). Mammographic features and breast cancer risk: effects with time, age, and menopause status. Journal of the National Cancer Institute, 87(21), 1622–1629.

Chikarmane, S. A., Offit, L. R., & Giess, C. S. (2023). Synthetic Mammography: Benefits, Drawbacks, and Pitfalls. Radiographics: A Review Publication of the Radiological Society of North America, Inc, 43(10), e230018. https://doi.org/10.1148/rg.230018

Daniel, B. L., & Ikeda, D. M. (2011). Chapter 7 - Magnetic Resonance Imaging of Breast Cancer and MRI-Guided Breast Biopsy. In D. M. Ikeda (Ed.), Breast Imaging (Second Edition) (pp. 239–296). Mosby.

DeMartini W & Lehman C, (2008). Top Magn Reson Imaging, Jun;19(3):143-50.

Dembrower, K., Liu, Y., Azizpour, H., Eklund, M., Smith, K., Lindholm, P., & Strand, F. (2020). Comparison of a Deep Learning Risk Score and Standard Mammographic Density Score for Breast Cancer Risk Prediction. Radiology, 294(2), 265–272.

Dembrower, K., Wåhlin, E., Liu, Y., Salim, M., Smith, K., Lindholm, P., Eklund, M., & Strand, F. (2020). Effect of artificial intelligence-based triaging of breast cancer screening mammograms on cancer detection and radiologist workload: a retrospective simulation study. The Lancet. Digital Health, 2(9), e468–e474.

Dibden, A., Offman, J., Duffy, S. W., & Gabe, R. (2020). Worldwide Review and Meta-Analysis of Cohort Studies Measuring the Effect of Mammography Screening Programmes on Incidence-Based Breast Cancer Mortality. Cancers, 12(4). https://doi.org/10.3390/cancers12040976

Duffy, S. W., Morrish, O. W. E., Allgood, P. C., Black, R., Gillan, M. G. C., Willsher, P., Cooke, J., Duncan, K. A., Michell, M. J., Dobson, H. M., Maroni, R., Lim, Y. Y., Purushothaman, H. N., Suaris, T., Astley, S. M., Young, K. C., Tucker, L., & Gilbert, F. J. (2018). Mammographic density and breast cancer risk in breast screening assessment cases and women with a family history of breast cancer. European Journal of Cancer, 88, 48–56.

Food and Drug Administration. (2001). The Mammography Quality Standards Act Final Regulations: Preparing for MQSA Inspections; Final Guidance for Industry and FDA.

Freeman, K., Geppert, J., Stinton, C., Todkill, D., Johnson, S., Clarke, A., & Taylor-Phillips, S. (2021). Use of artificial intelligence for image analysis in breast cancer screening programmes: systematic review of test accuracy. BMJ, 374, n1872.

Freer, P. E. (2015). Mammographic breast density: impact on breast cancer risk and implications for screening. Radiographics: A Review Publication of the Radiological Society of North America, Inc, 35(2), 302–315.

Garrett, J. W., Li, Y., Li, K., & Chen, G.-H. (2018). Reduced anatomical clutter in digital breast tomosynthesis with statistical iterative reconstruction. Medical Physics, 45(5), 2009–2022.

Geras, K. J., Mann, R. M., & Moy, L. (2019). Artificial Intelligence for Mammography and Digital Breast Tomosynthesis: Current Concepts and Future Perspectives. Radiology, 293(2), 246–259. https://doi.org/10.1148/radiol.2019182627

Giordano, L., von Karsa, L., Tomatis, M., Majek, O., de Wolf, C., Lancucki, L., Hofvind, S., Nyström, L., Segnan, N., Ponti, A., Eunice Working Group, Van Hal, G., Martens, P., Májek, O., Danes, J., von Euler-Chelpin, M., Aasmaa, A., Anttila, A., Becker, N., … Suonio, E. (2012). Mammographic screening programmes in Europe: organization, coverage and participation. Journal of Medical Screening, 19 Suppl 1, 72–82.

Harbeck, N., Penault-Llorca, F., Cortes, J., Gnant, M., Houssami, N., Poortmans, P., Ruddy, K., Tsang, J., & Cardoso, F. (2019). Breast cancer. Nature Reviews. Disease Primers, 5(1), 66. https://doi.org/10.1038/s41572-019-0111-2

Hickman, S. E., Baxter, G. C., & Gilbert, F. J. (2021). Adoption of artificial intelligence in breast imaging: evaluation, ethical constraints and limitations. British Journal of Cancer, 125(1), 15–22.

Hinton, B., Ma, L., Mahmoudzadeh, A. P., Malkov, S., Fan, B., Greenwood, H., Joe, B., Lee, V., Kerlikowske, K., & Shepherd, J. (2019). Deep learning networks find unique mammographic differences in previous negative mammograms between interval and screen-detected cancers: a case-case study. Cancer Imaging: The Official Publication of the International Cancer Imaging Society, 19(1), 41.

Hirko, K. A., Rocque, G., Reasor, E., Taye, A., Daly, A., Cutress, R. I., Copson, E. R., Lee, D.-W., Lee, K.-H., Im, S.-A., & Park, Y. H. (2022). The impact of race and ethnicity in breast cancer-disparities and implications for precision oncology.BMC Medicine, 20(1), 72.

Hong, R., & Xu, B. (2022). Breast cancer: an up-to-date review and future perspectives. Cancer Communications, 42(10), 913–936. https://doi.org/10.1002/cac2.12358

Hubbard, R. A., Kerlikowske, K., Flowers, C. I., Yankaskas, B. C., Zhu, W., & Miglioretti, D. L. (2011). Cumulative probability of false-positive recall or biopsy recommendation after 10 years of screening mammography: a cohort study.Annals of Internal Medicine, 155(8), 481–492.

Hu, K., Ding, P., Wu, Y., Tian, W., Pan, T., & Zhang, S. (2019). Global patterns and trends in the breast cancer incidence and mortality according to sociodemographic indices: an observational study based on the global burden of diseases. BMJ Open, 9(10), e028461.

Ikeda, D. M. (Ed.). (2011a). Chapter 2 - Mammogram Interpretation. In Breast Imaging (Second Edition) (pp. 24–62). Mosby.

Ikeda, D. M. (Ed.). (2011b). Chapter 5 - Breast Ultrasound. In Breast Imaging (Second Edition) (pp. 149–193). Mosby.

James, J. J., Giannotti, E., & Chen, Y. (2018). Evaluation of a computer-aided detection (CAD)-enhanced 2D synthetic mammogram: comparison with standard synthetic 2D mammograms and conventional 2D digital mammography. Clinical Radiology, 73(10), 886–892.

Kalager, M., Zelen, M., Langmark, F., & Adami, H.-O. (2010). Effect of screening mammography on breast-cancer mortality in Norway. The New England Journal of Medicine, 363(13), 1203–1210. https://doi.org/10.1056/NEJMoa1000727

Kim, Y.-S., Park, H.-S., Lee, H.-H., Choi, Y.-W., Choi, J.-G., Kim, H. H., & Kim, H.-J. (2016). Comparison study of reconstruction algorithms for prototype digital breast tomosynthesis using various breast phantoms. La Radiologia Medica, 121(2), 81–92.

Koo, M. M., von Wagner, C., Abel, G. A., McPhail, S., Rubin, G. P., & Lyratzopoulos, G. (2017). Typical and atypical presenting symptoms of breast cancer and their associations with diagnostic intervals: Evidence from a national audit of cancer diagnosis. Cancer Epidemiology, 48, 140–146. https://doi.org/10.1016/j.canep.2017.04.010

Lång, K., Josefsson, V., Larsson, A.-M., Larsson, S., Högberg, C., Sartor, H., Hofvind, S., Andersson, I., & Rosso, A. (2023). Artificial intelligence-supported screen reading versus standard double reading in the Mammography Screening with Artificial Intelligence trial (MASAI): a clinical safety analysis of a randomised, controlled, non-inferiority, single-blinded, screening accuracy study. The Lancet Oncology, 24(8), 936–944.

Lauritzen, A. D., Rodríguez-Ruiz, A., von Euler-Chelpin, M. C., Lynge, E., Vejborg, I., Nielsen, M., Karssemeijer, N., & Lillholm, M. (2022). An Artificial Intelligence-based Mammography Screening Protocol for Breast Cancer: Outcome and Radiologist Workload.Radiology, 304(1), 41–49.

Lehman, C. D., Yala, A., Schuster, T., Dontchos, B., Bahl, M., Swanson, K., & Barzilay, R. (2019). Mammographic Breast Density Assessment Using Deep Learning: Clinical Implementation. Radiology, 290(1), 52–58.

Leibig, C., Brehmer, M., Bunk, S., Byng, D., Pinker, K., & Umutlu, L. (2022). Combining the strengths of radiologists and AI for breast cancer screening: a retrospective analysis. The Lancet. Digital Health, 4(7), e507–e519.

Lei, J., Yang, P., Zhang, L., Wang, Y., & Yang, K. (2014). Diagnostic accuracy of digital breast tomosynthesis versus digital mammography for benign and malignant lesions in breasts: a meta-analysis. European Radiology, 24(3), 595–602.

Lekadir, K., Osuala, R., Gallin, C., Lazrak, N., Kushibar, K., Tsakou, G., Aussó, S., Alberich, L. C., Marias, K., Tsiknakis, M., Colantonio, S., Papanikolaou, N., Salahuddin, Z., Woodruff, H. C., Lambin, P., & Martí-Bonmatí, L. (2021). FUTURE-AI: Guiding Principles and Consensus Recommendations for Trustworthy Artificial Intelligence in Medical Imaging. In arXiv [cs.CV].arXiv. https://arxiv.org/abs/2109.09658

Liu, J., Zarshenas, A., Qadir, A., Wei, Z., Yang, L., Fajardo, L., & Suzuki, K. (2018). Radiation dose reduction in digital breast tomosynthesis (DBT) by means of deep-learning-based supervised image processing. Medical Imaging 2018: Image Processing, 10574, 89–97.

Liu, X., Cruz Rivera, S., Moher, D., Calvert, M. J., Denniston, A. K., & SPIRIT-AI and CONSORT-AI Working Group. (2020). Reporting guidelines for clinical trial reports for interventions involving artificial intelligence: the CONSORT-AI extension. Nature Medicine, 26(9), 1364–1374.

Łukasiewicz, S., Czeczelewski, M., Forma, A., Baj, J., Sitarz, R., & Stanisławek, A. (2021). Breast Cancer-Epidemiology, Risk Factors, Classification, Prognostic Markers, and Current Treatment Strategies-An Updated Review. Cancers, 13(17). https://doi.org/10.3390/cancers13174287

Lynge, E., Vejborg, I., Andersen, Z., von Euler-Chelpin, M., & Napolitano, G. (2019). Mammographic Density and Screening Sensitivity, Breast Cancer Incidence and Associated Risk Factors in Danish Breast Cancer Screening. Journal of Clinical Medicine Research, 8(11). https://doi.org/10.3390/jcm8112021

Mann, R. M., Cho, N., & Moy, L. (2019). Breast MRI: State of the Art. Radiology, 292(3), 520–536.

Martini, R., Newman, L., & Davis, M. (2022). Breast cancer disparities in outcomes; unmasking biological determinants associated with racial and genetic diversity. Clinical & Experimental Metastasis, 39(1), 7–14.

Mascara, M., & Constantinou, C. (2021). Global Perceptions of Women on Breast Cancer and Barriers to Screening. Current Oncology Reports, 23(7), 74.

McDonald, E. S., Clark, A. S., Tchou, J., Zhang, P., & Freedman, G. M. (2016). Clinical Diagnosis and Management of Breast Cancer. Journal of Nuclear Medicine: Official Publication, Society of Nuclear Medicine, 57 Suppl 1, 9S – 16S. https://doi.org/10.2967/jnumed.115.157834

McKinney, S. M., Sieniek, M., Godbole, V., Godwin, J., Antropova, N., Ashrafian, H., Back, T., Chesus, M., Corrado, G. S., Darzi, A., Etemadi, M., Garcia-Vicente, F., Gilbert, F. J., Halling-Brown, M., Hassabis, D., Jansen, S., Karthikesalingam, A., Kelly, C. J., King, D., … Shetty, S. (2020). International evaluation of an AI system for breast cancer screening. Nature, 577(7788), 89–94.

Mohamed, A. A., Berg, W. A., Peng, H., Luo, Y., Jankowitz, R. C., & Wu, S. (2018). A deep learning method for classifying mammographic breast density categories. Medical Physics, 45(1), 314–321.

Moran, S., & Warren-Forward, H. (2012). The Australian BreastScreen workforce: a snapshot. The Radiographer, 59(1), 26–30.

Nelson, H. D., Fu, R., Cantor, A., Pappas, M., Daeges, M., & Humphrey, L. (2016). Effectiveness of Breast Cancer Screening: Systematic Review and Meta-analysis to Update the 2009 U.S. Preventive Services Task Force Recommendation. Annals of Internal Medicine, 164(4), 244–255.

Nelson, H. D., Pappas, M., Cantor, A., Griffin, J., Daeges, M., & Humphrey, L. (2016). Harms of Breast Cancer Screening: Systematic Review to Update the 2009 U.S. Preventive Services Task Force Recommendation. Annals of Internal Medicine, 164(4), 256–267.

Nguyen, H. T., Nguyen, H. Q., Pham, H. H., Lam, K., Le, L. T., Dao, M., & Vu, V. (2023). VinDr-Mammo: A large-scale benchmark dataset for computer-aided diagnosis in full-field digital mammography. Scientific Data, 10(1), 277.

Ong, M.-S., & Mandl, K. D. (2015). National expenditure for false-positive mammograms and breast cancer overdiagnoses estimated at $4 billion a year. Health Affairs , 34(4), 576–583.

Prevedello, L. M., Halabi, S. S., Shih, G., Wu, C. C., Kohli, M. D., Chokshi, F. H., Erickson, B. J., Kalpathy-Cramer, J., Andriole, K. P., & Flanders, A. E. (2019). Challenges Related to Artificial Intelligence Research in Medical Imaging and the Importance of Image Analysis Competitions. Radiology. Artificial Intelligence, 1(1), e180031. https://doi.org/10.1148/ ryai.2019180031

Raya-Povedano, J. L., Romero-Martín, S., Elías-Cabot, E., Gubern-Mérida, A., Rodríguez-Ruiz, A., & Álvarez-Benito, M. (2021). AI-based Strategies to Reduce Workload in Breast Cancer Screening with Mammography and Tomosynthesis: A Retrospective Evaluation. Radiology, 300(1), 57–65.

Rimmer, A. (2017). Radiologist shortage leaves patient care at risk, warns royal college. BMJ, 359, j4683.

Skaane, P., Bandos, A. I., Niklason, L. T., Sebuødegård, S., Østerås, B. H., Gullien, R., Gur, D., & Hofvind, S. (2019). Digital Mammography versus Digital Mammography Plus Tomosynthesis in Breast Cancer Screening: The Oslo Tomosynthesis Screening Trial. Radiology, 291(1), 23–30.

Sung H et al,(2021). CA Cancer J Clin, 2021 May;71(3):209-249. doi: 10.3322/caac.21660

Tabár, L., Dean, P. B., Chen, T. H.-H., Yen, A. M.-F., Chen, S. L.- S., Fann, J. C.-Y., Chiu, S. Y.-H., Ku, M. M.-S., Wu, W. Y.-Y., Hsu, C.-Y., Chen, Y.-C., Beckmann, K., Smith, R. A., & Duffy, S. W. (2019). The incidence of fatal breast cancer measures the increased effectiveness of therapy in women participating in mammography screening. Cancer, 125(4), 515–523.

Svahn, T. M., Houssami, N., Sechopoulos, I., & Mattsson, S. (2015). Review of radiation dose estimates in digital breast tomosynthesis relative to those in two-view full-field digital mammography. Breast, 24(2), 93–99. https://doi.org/10.1016/j. breast.2014.12.002

Tirada, N., Li, G., Dreizin, D., Robinson, L., Khorjekar, G., Dromi, S., & Ernst, T. (2019). Digital Breast Tomosynthesis: Physics, Artifacts, and Quality Control Considerations. Radiographics: A Review Publication of the Radiological Society of North America, Inc, 39(2), 413–426.

Torres-Mejía, G., De Stavola, B., Allen, D. S., Pérez-Gavilán, J. J., Ferreira, J. M., Fentiman, I. S., & Dos Santos Silva, I. (2005). Mammographic features and subsequent risk of breast cancer: a comparison of qualitative and quantitative evaluations in the Guernsey prospective studies. Cancer Epidemiology, Biomarkers & Prevention: A Publication of the American Association for Cancer Research, Cosponsored by the American Society of Preventive Oncology, 14(5), 1052–1059.

Volpara Health. (2022). TruPGMI: AI for mammography quality improvement. https://www.volparahealth.com/breast-healthsoftware/ products/analytics/

Wing, P., & Langelier, M. H. (2009). Workforce shortages in breast imaging: impact on mammography utilization. AJR. American Journal of Roentgenology, 192(2), 370–378.

Yala, A., Lehman, C., Schuster, T., Portnoi, T., & Barzilay, R. (2019). A Deep Learning Mammography-based Model for Improved Breast Cancer Risk Prediction. Radiology, 292(1), 60–66.

Yala, A., Schuster, T., Miles, R., Barzilay, R., & Lehman, C. (2019). A Deep Learning Model to Triage Screening Mammograms: A Simulation Study. Radiology, 293(1), 38–46.

PP-CALA-DE-0241